Vous avez détecté la version gagnante de votre test A/B et vous venez de l’arrêter ? Voici les 5 choses que je vous conseille de mettre en œuvre immédiatement après l’arrêt d’un test :

1. Maintenir la version gagnante sur 95%

Maintenir la version détectée gagnante via l’outil de testing est une bonne pratique des équipes CRO. Le premier avantage est de bénéficier des gains tout de suite et sur l’ensemble du trafic. Le second est que cette étape se fait sans mise en production complète. Une simple modification de la répartition du trafic fera l’affaire.

Cette technique présente aussi des inconvénients à traiter au cas par cas. Le premier est que le développement de la version gagnante par la DSI peut prendre du temps. Pendant cette phase, votre combinaison de test peut être affectée par des mises en production ou d’autres évolutions. Le risque financier peut-être important si l’interface est perturbée et pour palier à ce problème, je vous conseille de placer votre combinaison sur seulement 95 % du trafic. Vous aurez alors la capacité à détecter des incidents de performance depuis votre dashboard d’outil de testing ou analytics.

L’autre point négatif est le fait de consommer de la bande passante de test A/B. En effet, si votre outil est configuré sur 1 visiteur = 1 test et que vous ciblez 95 % du périmètre, vous ne pourrez lancer d’autres tests A/B. La solution est soit de basculer cette combinaison gagnante dans une personnalisation. Plusieurs solutions de testing proposent cette fonctionnalité (ABTasty, Kameleoon, Optimizely, …). Autrement, vous pouvez réduire la part de trafic de cette combinaison gagnante pour continuer vos tests A/B.

2. Un bilan détaillé du test A/B

Quel est l’impact sur les KPIs intermédiaires ? Quel est l’impact sur le comportement utilisateur de chacun des éléments que vous avez testé ? Quels impacts sur la façon de naviguer sur le site ? Quels segments des utilisateurs sont impactés positivement ? Négativement ? …

Ces questions permettent de vérifier qu’une combinaison de test A/B est réellement gagnante. Un gain au global positif et un indice de confiance supérieur à 95 % ne garantissent pas un test positif. Un indicateur secondaire peut devenir négatif et avoir un impact plus important à long terme.

Ces recherches vous permettront de détecter des précieux enseignements qui influeront sur votre roadmap d’optimisation ainsi que sur les projets à venir.

3. Définir de nouvelles hypothèses

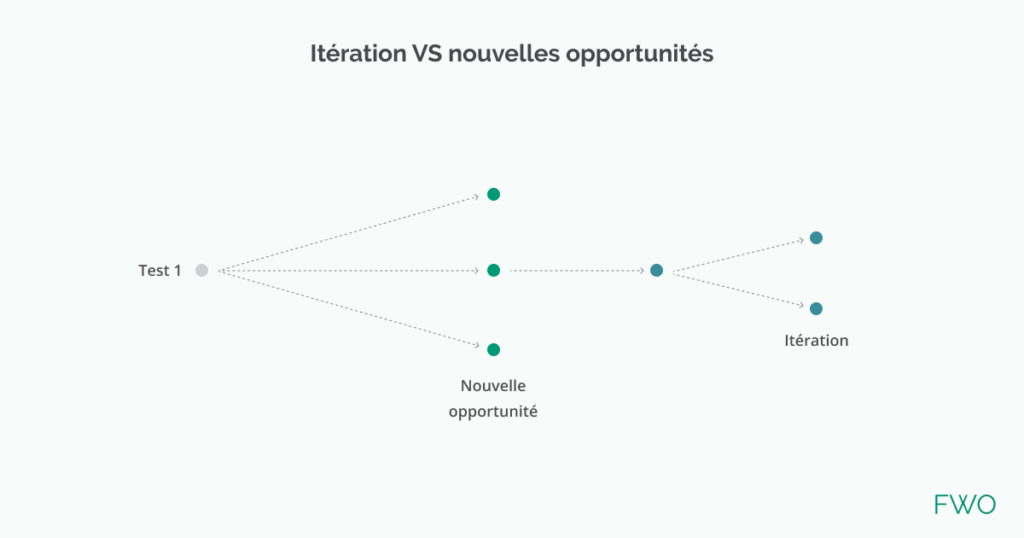

À la suite d’un test A/B, vous avez 2 possibilités :

- Itérer sur votre hypothèse de départ pour optimiser un point précis

- Développer des nouvelles opportunités

Après avoir tiré des enseignements d’une expérimentation grâce au bilan détaillé, il est vital de définir de nouvelles opportunités d’optimisation.

Prenons le cas d’un test qui montre qu’il est important de valoriser la description de la fiche produit par exemple. À la vue de ce résultat, il sera intéressant de tester différentes manières de présenter ce contenu, le ton rédactionnel, sa hiérarchie visuelle ou encore son positionnement au sein de la page.

En bref le CRO est un processus itératif où chaque réponse amène de nouvelles questions.

4. Calculer le coût de l’expérimentation

Combien ont rapporté la ou les versions sur-performantes pendant le test ? Combien ont coûté les versions sous-performantes ? Calculer ce différentiel permet de connaitre le coût ou les gains apportés par le programme d’optimisation sur une période donnée.

Cet indicateur vous permettra, à terme, de piloter le niveau de risque business en amont de chaque expérimentation.

5. Actualiser la roadmap d’optimisation

Vous avez défini de nouvelles hypothèses à tester ? Il est donc temps de les intégrer et de les prioriser au sein de la roadmap d’optimisation pour déterminer la prochaine action sur laquelle avancer.

En synthèse les trois maîtres-mots d’une période post-test réussie sont : analyse, itération, priorisation !

Et vous ? Quelles actions faites-vous lorsque vous arrêtez un test ?