Les tests A/B sont un outil essentiel pour les équipes produits pour comprendre comment construire ses features, maîtriser le risque et apprendre. Néanmoins dans de nombreux programmes d’expérimentations, ces tests A/B ont un impact trop souvent faible voir totalement neutre.

Alors pourquoi tant de tests A/B aboutissent-ils à des résultats neutres ?

Comment renverser cette situation pour obtenir des tests réellement efficaces ?

Pourquoi les Tests A/B sont Parfois Inefficaces

3 raisons majeures expliquer pourquoi les tests A/B ont peu d’impacts significatifs :

- Hypothèses faibles ou non argumentées : Si l’hypothèse sous-jacente au test A/B est mal définie ou ne repose pas sur des données solides, les chances de succès sont minimes. Tester quelque chose qui n’intéresse pas réellement l’utilisateur conduit inévitablement à des résultats plats.

- Mise en Œuvre partielle ou mal conçue : Une conception qui n’applique que partiellement une hypothèse ou qui génère des effets de bord peut annuler tous les bénéfices attendus. Par exemple, une modification de design qui introduit des éléments confus pour l’utilisateur peut annihiler les gains potentiels du test.

- Modifications trop subtiles : Même si une modification a un effet positif, si elle est trop subtile pour être perçue par l’utilisateur, l’impact sera limité. Il est crucial que les changements soient suffisamment visibles pour produire un effet mesurable. Pensez radical et dépassez les limites du design system !

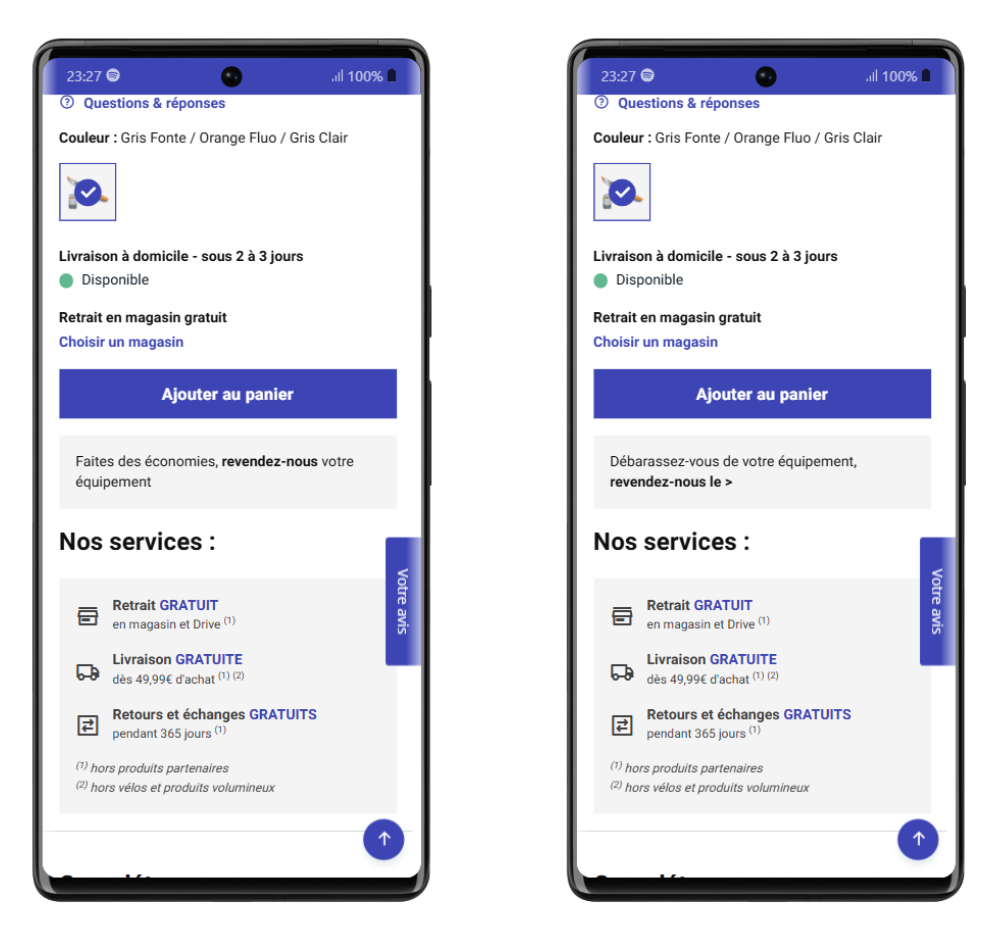

Dans cet exemple de Décathlon, l’équipe peut inciter les utilisateurs à revendre leur matériel. Les problèmes sont que le texte est peu percutant et la forme est peu affordante. Elle ressemble au bloc de réassurance juste en dessous qui lui n’a pas vocation à être cliqué.

La variation proposée dans cet exemple tente d’optimiser la compréhension du service, mais sans améliorer l’affordance et la forme de la zone. L’accès au service sera probablement en légèrement en hausse, mais bien en-dessous de ce que pourrait faire une équipe qui corrigerait aussi la forme.

3 solutions pour améliorer vos tests A/B

Pour augmentez le nombre de tests A/B qui impactent le comportement utilisateur, voici 3 solutions simples pour les leads CRO :

- Identifier toutes les difficultés du problème : Avant de lancer un test, il est essentiel de bien comprendre le problème dans sa globalité. Par exemple, si un produit n’est pas suffisamment revendu sur une plateforme comme Decathlon, il ne suffit pas de changer le libellé d’un CTA. Il faut aussi s’assurer que le design du CTA soit attractif et visible. Traiter le fond et la forme simultanément est clé pour maximiser l’impact d’un test.

- Tester l’efficacité du design avec des tests de 5 secondes : Pour s’assurer que les modifications sont comprises par les utilisateurs, il est recommandé de réaliser des tests de 5 secondes. Montrez vos deux versions de design à un échantillon d’utilisateurs et demandez-leur ce qu’ils en retiennent. Si des incompréhensions ou des doutes subsistent, retravaillez le design avant de lancer le test à grande échelle.

- Aller plus loin dans la conception : Pour maximiser l’impact, il est important de vérifier la visibilité des modifications dans l’interface et de bien gérer la hiérarchie de l’information. Utiliser des outils comme le floutage de maquettes peut aider à identifier l’ordre de perception des éléments par les utilisateurs. De plus, bien que les systèmes de design des grandes organisations puissent être limitants, il ne faut pas hésiter à les bousculer pour trouver des solutions plus adaptées.

Conclusion : prendre des risques pour obtenir des résultats

Incitez les équipes à être audacieuses dans leurs tests A/B. Il vaut mieux obtenir un résultat significatif, qu’il soit positif ou négatif, plutôt que de stagner avec des résultats plats après des semaines d’attente. La clé du succès réside dans l’expérimentation audacieuse et l’apprentissage constant.

En suivant ces conseils, vous pourrez transformer vos tests A/B en un outil puissant pour optimiser vos produits et services.

Bonne optimisation à tous !